Nepaisant prižiūrimo mašininio ir gilaus mokymosi sėkmės, egzistuoja minties mokykla, sakanti, kad neprižiūrimas mokymasis turi dar didesnį potencialą. Prižiūrimos mokymosi sistemos mokymąsi riboja jos mokymas; y., prižiūrima mokymosi sistema gali išmokti tik tas užduotis, kurioms ji yra apmokyta. Priešingai, neprižiūrima sistema teoriškai galėtų pasiekti „dirbtinį bendrąjį intelektą“, reiškiantį gebėjimą išmokti bet kokią žmogaus užduotį. Tačiau technologijos dar nėra.

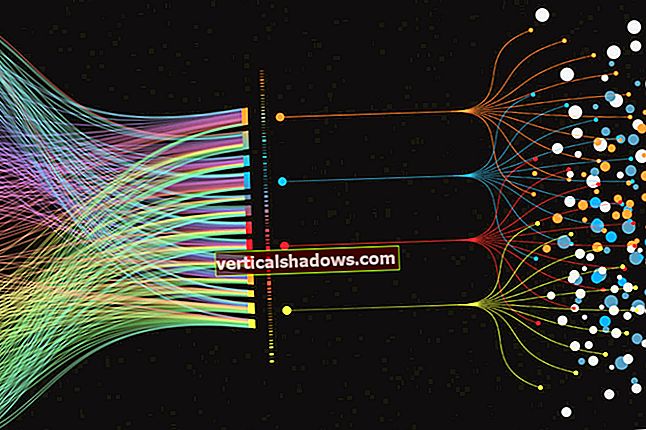

Jei didžiausia prižiūrimo mokymosi problema yra mokymo duomenų žymėjimo sąskaita, didžiausia neprižiūrimo mokymosi problema (kai duomenys nėra paženklinti etiketėmis) yra ta, kad ji dažnai neveikia labai gerai. Nepaisant to, neprižiūrimas mokymasis tikrai turi savo naudos: kartais tai gali būti naudinga norint sumažinti duomenų rinkinio matmenį, ištirti duomenų modelį ir struktūrą, surasti panašių objektų grupes ir aptikti pašalinius duomenis bei kitą triukšmą duomenyse.

Apskritai verta išbandyti neprižiūrimus mokymosi metodus kaip dalį tiriamosios duomenų analizės, kad būtų galima atrasti modelius ir grupes, sumažinti duomenų matmenį, atrasti latentines ypatybes ir pašalinti pašalinius dalykus. Ar jums reikės pereiti prie prižiūrimo mokymosi, ar naudoti iš anksto parengtus modelius prognozėms atlikti, priklauso nuo jūsų tikslų ir jūsų duomenų.

Kas yra neprižiūrimas mokymasis?

Pagalvokite, kaip mokosi žmonių vaikai. Kaip tėvams ar mokytojams nereikia parodyti mažiems vaikams visų šunų ir kačių veislių, kad išmokytumėte juos atpažinti šunis ir kates. Jie gali mokytis iš kelių pavyzdžių, be daugybės paaiškinimų, ir patys apibendrinti. O, jie gali per klaidą pirmą kartą pamatę čihuahua vadinti „Kitty“, bet jūs galite tai palyginti greitai ištaisyti.

Vaikai intuityviai suskirsto matomų daiktų grupes į klases. Vienas neprižiūrimo mokymosi tikslas iš esmės yra leisti kompiuteriams išsiugdyti tą patį gebėjimą. Alexas Gravesas ir Kelly Clancy iš „DeepMind“ savo tinklaraščio įraše „Neprižiūrėtas mokymasis: smalsus mokinys“

Neprižiūrimas mokymasis yra paradigma, sukurta siekiant sukurti autonominį intelektą, atlyginant agentams (tai yra kompiuterinėms programoms), kad jie sužinotų apie stebimus duomenis, nepamiršdami tam tikros užduoties. Kitaip tariant, agentas mokosi vardan mokymosi.

Agento, besimokančio dėl mokymosi, potencialas yra daug didesnis nei sistemos, kuri sudėtingus paveikslėlius paverčia dvinariu sprendimu (pvz., Šuo ar katė). Šablonų atskleidimas, o ne iš anksto nustatytos užduoties atlikimas gali duoti stebėtinus ir naudingus rezultatus, kaip įrodyta, kai Lawrence'o Berkeley laboratorijos mokslininkai paleido teksto apdorojimo algoritmą (Word2vec) ant kelių milijonų medžiagų mokslo santraukų, kad numatytų naujų termoelektrinių medžiagų atradimus.

Grupavimo metodai

Grupavimo problema yra neprižiūrima mokymosi problema, dėl kurios modelis reikalauja surasti panašių duomenų taškų grupes. Šiuo metu yra keletas grupavimo algoritmų, kurie paprastai turi šiek tiek kitokias charakteristikas. Apskritai grupių algoritmai žiūri į metriką ar atstumo funkcijas tarp duomenų taškų ypatybių vektorių ir sugrupuoja vienas kitą „arti“. Klasterių algoritmai geriausiai veikia, jei klasės nesutampa.

Hierarchinis grupavimas

Hierarchinė klasterių analizė (HCA) gali būti aglomeracinė (klasterius kuriate iš apačios į viršų, pradedant nuo atskirų taškų ir baigiant vienu klasteriu) arba skaldanti (pradedate nuo vieno klasterio ir suskirstote jį tol, kol baigsite atskirus taškus). Jei jums pasisekė, galite rasti tarpinį grupavimo proceso etapą, kuris atspindi prasmingą klasifikaciją.

Grupavimo procesas paprastai rodomas kaip dendrograma (medžio diagrama). HCA algoritmai paprastai užima daug skaičiavimo laiko [O(n3)] ir atmintis [O(n2)] ištekliai; tai riboja algoritmų pritaikymą palyginti mažiems duomenų rinkiniams.

HCA algoritmai gali naudoti įvairią metriką ir susiejimo kriterijus. Euklido atstumas ir kvadratas Euklido atstumas yra dažni skaitiniams duomenims; Hammingo atstumas ir Levenshteino atstumas yra įprasti ne skaitmeniniams duomenims. Paprasta yra viena jungtis ir visiškas ryšys; abu šie elementai gali supaprastinti grupavimo algoritmus (atitinkamai SLINK ir CLINK). SLINK yra vienas iš nedaugelio grupavimo algoritmų, užtikrinančių optimalų sprendimą.

K reiškia grupavimą

K reiškia klasterio problemą, kurią bandoma padalyti n stebėjimai į k klasteriai, naudojantys Euklido atstumo metriką, siekiant sumažinti kiekvieno klasterio dispersiją (kvadratų sumą). Tai vektorių kvantavimo metodas ir yra naudingas mokantis funkcijų.

Lloydo algoritmas (iteracinė klasterių aglomeracija su centroidiniais atnaujinimais) yra dažniausiai naudojama problemai spręsti naudojama euristika ir yra gana efektyvi, tačiau negarantuoja visuotinės konvergencijos. Norėdami tai pagerinti, žmonės dažnai kelis kartus paleidžia algoritmą naudodami atsitiktinius pradinius sankaupos centroidus, sukurtus „Forgy“ arba „Random Partition“ metodais.

K reiškia reiškia sferinius klasterius, kuriuos galima atskirti, kad vidurkis sutelktųsi į klasterio centrą, taip pat daroma prielaida, kad duomenų taškų išdėstymas nėra svarbus. Tikimasi, kad klasteriai bus panašaus dydžio, todėl priskyrimas artimiausiam klasterio centrui yra teisingas priskyrimas.

K vidurkio klasterių sprendimo euristika paprastai yra panaši į Gauso mišinio modelių lūkesčių maksimizavimo (EM) algoritmą.

Mišinio modeliai

Mišinio modeliuose daroma prielaida, kad stebėjimų pogrupiai atitinka tam tikrą tikimybių pasiskirstymą, dažniausiai Gauso skirstiniai skaitiniams stebėjimams arba kategoriniai skirstiniai ne skaitmeniniams duomenims. Kiekvienas pogrupis gali turėti savo pasiskirstymo parametrus, pavyzdžiui, Gauso skirstinių vidurkį ir dispersiją.

Laukimo maksimizavimas (EM) yra viena iš populiariausių metodų, naudojamų nustatant mišinio su nurodytu komponentų skaičiumi parametrus. Be EM, mišinių modelius galima išspręsti naudojant Markovo grandinę „Monte Carlo“, momentų derinimą, spektrinius metodus su atskiros vertės skaidymu (SVD) ir grafinius metodus.

Pradinis mišinio modelio taikymas buvo atskirti dvi kranto krabų populiacijas pagal kaktos ir kūno ilgio santykį. Karlas Pearsonas 1894 m. Išsprendė šią problemą naudodamas momentų derinimą.

Bendras mišinio modelių išplėtimas yra susieti latentinius kintamuosius, apibrėžiančius mišinio komponentų tapatybes, į Markovo grandinę, užuot manius, kad jie yra nepriklausomi identiškai paskirstyti atsitiktiniai kintamieji. Gautas modelis vadinamas paslėptu Markovo modeliu ir yra vienas iš labiausiai paplitusių nuoseklių hierarchinių modelių.

DBSCAN algoritmas

Tankiu pagrįstas erdvinis programų su triukšmu klasteris (DBSCAN) yra neparametrinis duomenų grupavimo algoritmas, sukurtas 1996 m. Jis yra optimizuotas naudoti su duomenų bazėmis, kurios gali pagreitinti geometrinių regionų užklausas naudodamos R * medį ar kitą geometrinio indekso struktūrą. .

Iš esmės, DBSCAN grupės pagrindinius dalykus turintys daugiau nei tam tikrą minimalų kaimynų skaičių tam tikru atstumu „Epsilon“, atmeta kaip pašalinius taškus, kurie neturi „Epsilon“ kaimynų, ir prideda taškus, esančius „Epsilon“ centre, prie tos grupės. DBSCAN yra vienas iš labiausiai paplitusių grupavimo algoritmų ir gali rasti savavališkos formos klasterius.

OPTICS algoritmas

Taškų išdėstymas grupavimo struktūrai identifikuoti (OPTICS) yra algoritmas, pagal kurį erdviniuose duomenyse galima rasti tankiu pagrįstas grupes. OPTICS yra panaši į DBSCAN, tačiau taiko kintamo taško tankio atvejus.

DBSCAN ir OPTICS idėjų variantai taip pat gali būti naudojami paprastam triukšmo aptikimui ir pašalinimui.

Latentiniai kintamieji modeliai

Latentinio kintamojo modelis yra statistinis modelis, susiejantis stebimų kintamųjų rinkinį su latentinių (paslėptų) kintamųjų rinkiniu. Latentiniai kintamieji modeliai yra naudingi atskleidžiant paslėptas struktūras sudėtinguose ir didelės dimensijos duomenyse.

Pagrindinio komponento analizė

Pagrindinio komponento analizė (PCA) yra statistinė procedūra, pagal kurią atliekama stačiakampė transformacija, kad galimai koreliuojančių skaitinių kintamųjų stebėjimų rinkinys būtų paverstas linijiškai nekoreliuotų kintamųjų reikšmių rinkiniu, vadinamu pagrindiniais komponentais. Karlas Pearsonas išrado PCA 1901 m. PCA gali būti įvykdytas išskaidant duomenų kovariacijos (arba koreliacijos) matricą arba atskiros vertės skaidymą (SVD) duomenų matricoje, paprastai po pradinių duomenų normalizavimo žingsnio.

Vienkartinės vertės skaidymas

Vienkartinės reikšmės skaidymas (SVD) yra tikrosios arba kompleksinės matricos faktorizavimas. Tai įprasta tiesinės algebros technika ir dažnai apskaičiuojama naudojant Householderio transformacijas. SVD yra vienas iš būdų išspręsti pagrindinius komponentus. Nors SVD koduoti visiškai įmanoma nuo nulio, visose linijinės algebros bibliotekose yra gerų įdiegimų.

Akimirkų metodas

Akimirkų metodas naudoja populiacijos parametrus įvertinto duomenų imties momentais (vidurkis, dispersija, iškrypimas ir kurtozė). Metodas yra gana paprastas, jį dažnai galima apskaičiuoti rankomis ir paprastai pasiekiama visuotinė konvergencija. Žemos statistikos atveju, taikant momentų metodą, kartais galima gauti įverčius, esančius už parametrų erdvės ribų. Akimirkų metodas yra lengvas būdas išspręsti mišinių modelius (aukščiau).

Laukimo-maksimizavimo algoritmai

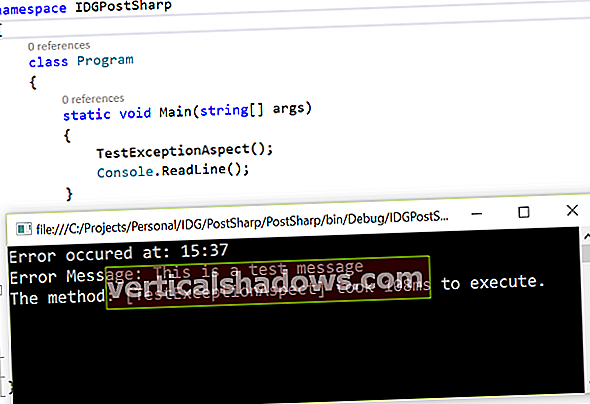

Lūkesčių maksimizavimo (EM) algoritmas yra iteracinis metodas, leidžiantis rasti maksimalų parametrų tikimybės įverčius modeliuose, kurie priklauso nuo nepastebėtų latentinių kintamųjų. EM iteracija keičiasi laukimo žingsnio (E) atlikimu, kuris sukuria log-tikimybės tikimybės, įvertintos naudojant dabartinį parametrų įvertinimą, laukimo funkciją ir maksimalizavimo žingsnį (M), kuris apskaičiuoja parametrus, maksimaliai padidinančius laukiamą log-log tikimybė nustatyta E pakopoje.

EM konverguoja į maksimalų ar balno tašką, bet nebūtinai į pasaulinį maksimumą. Galite padidinti tikimybę rasti visuotinį maksimumą pakartodami EM procedūrą iš daugelio atsitiktinių pradinių parametrų įvertinimų arba naudodami momentų metodą nustatydami pradinius įvertinimus.

Klasterinei analizei galima naudoti EM, taikomą Gauso mišinio modeliui (aukščiau).

Neprižiūrimi neuroniniai tinklai

Neuroniniai tinklai paprastai mokomi klasifikuoti ar regresuoti paženklintus duomenis, kurie pagal apibrėžimą yra prižiūrimi mašininiai mokymai. Jie taip pat gali būti mokomi naudoti nepaženklintus duomenis, naudojant įvairias neprižiūrimas schemas.

Autokoderiai

Autokoderiai yra neuroniniai tinklai, kurie yra apmokyti dėl jų įvesties. Iš esmės, automatinis koderis yra perdavimo tinklas, veikiantis kaip kodekas, koduojantis jo įvestį iš įvesties sluoksnio į vieną ar daugiau paslėptų sluoksnių su mažesniu neuronų skaičiumi, o tada dekoduoja koduotą vaizdą į išvesties sluoksnį, kurio topologija yra įvestis.

Treniruotės metu automatinis koderis naudoja sklidimą atgal, kad sumažintų skirtumą tarp įvesties ir išvesties. Automatiniai koduotojai buvo naudojami matmenų mažinimui, funkcijų mokymuisi, triukšmo pašalinimui, anomalijų aptikimui, vaizdo apdorojimui ir generatyvinių modelių mokymuisi.

Gilių įsitikinimų tinklai

Gilių įsitikinimų tinklai (DBN) yra autokoderių ar ribotų „Boltzmann“ mašinų (RBN), galinčių išmokti rekonstruoti savo įvestį, krūvos. Tada sluoksniai veikia kaip funkcijų detektoriai. RBN paprastai mokomi naudojant kontrastinį divergenciją.

DBN buvo naudojami vaizdams, vaizdo sekoms ir judesio fiksavimo duomenims generuoti ir atpažinti.

Generaciniai rungimosi tinklai

Generatyvūs rungimosi tinklai (GAN) vienu metu treniruoja du tinklus, generatyvų modelį, kuris fiksuoja duomenų pasiskirstymą, ir diskriminacinį modelį, kuris įvertina tikimybę, kad imtis atsirado iš mokymo duomenų. Mokymo metu bandoma maksimaliai padidinti tikimybę, kad generatorius gali apgauti diskriminatorių.

GAN gali būti naudojami įsivaizduojamų žmonių nuotraukoms kurti ir astronominiams vaizdams tobulinti. GAN taip pat buvo naudojamas išplėsti senų vaizdo žaidimų tekstūras, skirtas naudoti didelės raiškos žaidimų versijose. Be neprižiūrimo mokymosi, GAN buvo sėkmingai pritaikyti stiprinant žaidimo mokymąsi.

Savitvarkos žemėlapis

Savitvarkos žemėlapis (SOM) apibrėžia sutvarkytą atvaizdavimą iš tam tikrų duomenų elementų rinkinio į įprastą, paprastai dviejų matmenų tinklelį. Su kiekvienu tinklelio mazgu susietas modelis. Duomenų elementas bus susietas su mazgu, kurio modelis yra panašiausias į duomenų elementą, t. Y. Turi mažiausią atstumą nuo duomenų elemento tam tikroje metrikoje.

Yra keletas atsargumo priemonių, kurių turite imtis, kad susiejimai būtų stabilūs ir gerai užsakyti. Ne visuose komerciniuose diegimuose laikomasi visų atsargumo priemonių.